최현석 , 이한건 , 이영훈

AI 딥러닝 모델에 따른 원단 결점 분석에 대한 연구

A Study on the Fabric Defect Analysis Using Machine AI Deep Learning Models

Hyunseuk Choi, Hangeon Lee, and Yeonghun Lee

Abstract: This study presents a comparative analysis of representative object detectionbased AI deep learning models(YOLOv4, YOLOX, RT-DETR) to enhance the accuracy and real-time performance of fabric defect detection, a critical step in textile manufacturing processes. Experimental results indicate that RT-DETR outperforms the other models in Accuracy, Recall, and F1-Score, with the exception of Precision. In particular, RT-DETR demonstrates a significantly higher Recall, suggesting its suitability for product categories where defect omission is unacceptable. This superiority appears to stem from its Transformer-based architecture, which effectively captures global features in textile images characterized by repetitive patterns and complex surface textures. However, RT-DETR exhibits a maximum processing speed of approximately 130 FPS, which is lower compared to the other models. While it is sufficient for general manufacturing processes, it may impose limitations in ultra-high-speed production environments. Overall, the findings confirm that the Transformer-based RT-DETR model represents the most suitable option for fabric defect analysis using AI deep learning techniques.

Keywords: deep learning , object detection , defect analysis , artificial intelligence , fabric inspection

1. 서 론

섬유는 패션 및 라이프 스타일에서 의료용 또는 자동차 산업에 이르기까지 상상할 수 있는 거의 모든 산업에서 사용된다. 이렇게 다양한 산업 분야에 사용되는 섬유의 제조 공정에서 제조 결과물이 우수하려면 생산된 원단의 품질관리 및 평가의 특성을 유지하는 것은 섬유 업체의 생산 공정에서 중요한 요소이다. 특히 최근 섬유 산업은 다품종 소량생산 체제로 전환함과 동시에 패스트 패션, 지속가능 패션이 혼재되면서 원단의 조직, 색상, 표면 특성 등이 더욱 복잡해지고 다양해지고 있다. 이러한 변화는 생산 공정 전반에서 결함 검출의 중요성을 높이고 있으며, 특히 고속 고해상도 검사 장비와 연계된 정밀 결점 분석 기술의 필요성이 증가하고 있다.

섬유 원단은 원사 제조, 제·편직, 전처리 및 염색, 가공, 후가공, 검사에 이르는 복합적인 공정을 통해 생산되며, 표면 결점은 검사 공정을 제외한 대부분의 제조 단계에서 발생할 수 있는 것으로 알려져 있다. 이론적으로는 공정 단계별 품질 관리가 요구되지만, 실제 생산 환경에서는 공정 수의 증가와 생산 라인의 고속화로 인해 모든 공정을 대상으로 한 전수 검사가 현실적으로 어렵다. 이에 따라 다수의 섬유 제조 현장에서는 제·편직 단계와 최종 원단 검사 공정에 품질 검사가 집중되는 구조를 보이고 있다. 현재까지 가장 널리 사용되는 검사 방식은 숙련 작업자의 육안 검사를 기반으로 한 수동 검사 방식으로, 검단기를 이용해 이송되는 원단 표면을 작업자가 직접 관찰하며 결점을 판별한다. 그러나 선행연구들에서는 이러한 수동 검사 방식이 작업자의 숙련도와 주관적 판단에 크게 의존하며, 반복 작업에 따른 피로 누적으로 인해 결점 누락과 오검출 가능성이 증가하는 구조적 한계를 가진다고 보고하고 있다. 또한 생산 속도가 증가할수록 수동 검사는 실시간 공정 대응이 어렵고 검사 품질의 일관성을 유지하기 힘들다는 점이 반복적으로 지적되고 있다[1−3]. 이와 같은 수동 검사 방식의 한계를 보완하기 위해 최근 들어 머신비전 기반 비전검사장비가 대안으로 제시되어 왔으며, 일부 섬유 검사 공정에서는 자동화된 비전 검사 시스템이 도입되어 운영되고 있다. 비전검사장비는 카메라와 조명 시스템을 통해 획득한 영상을 분석하여 제품 상태를 자동으로 판별하는 시스템으로, 이미지 획득, 결함 검출, 검사 결과 출력까지를 포함하는 통합 검사 솔루션으로 정의된다[4]. 그러나 기존의 image processing 기반 비전 검사 시스템은 사전에 정의된 규칙이나 저수준 특징에 의존하는 특성으로 인해 조명 변화, 색상 편차, 표면 질감 변화에 민감하며, 다양한 소재와 패턴이 혼재된 섬유 산업 환경에서는 안정적인 적용에 한계가 있다. 최근 선행연구에서는 이러한 전통적 영상 처리 기반 검사 방식이 복잡한 텍스처를 가지는 표면 결점이나 정상 패턴과 유사한 결함을 충분히 구분하지 못하며, 환경 변화에 대한 일반화 성능이 제한적이라는 점을 지적하고 있다. 또한 다품종 소량 생산 구조에서는 검사 조건의 빈번한 변경이 요구되어 시스템 재설정과 유지 비용이 증가하며, 기존 비전검사장비는 결점의 존재 여부 판단에는 활용이 가능하나 결점 특성에 대한 정량적 분석이나 복합적인 결점 해석에는 한계가 있다는 점이 보고되고 있다.

이러한 부분을 해결하는 방법으로 최근 AI 딥러닝 기술을 도입한 AI 기반 머신비전 기술이 대두되고 있다. 특히 객체 검출(object detection) 모델과 이상 탐지(anomaly detection) 모델은 다양한 산업 분야에서 우수한 성능을 입증하며 섬유 결함 검사 분야에서도 활발히 연구되고 있다. 그러나 실제 제조 환경에서는 결함 이미지의 확보가 어렵고, 원단의 종류·패턴·색상에 따른 모델 재학습 부담이 커 anomaly detection 모델의 적용에 실질적 제약이 존재한다. 더불어 중소 섬유 업체의 현실적인 GPU 인프라 한계는 대규모 모델 운영의 난이도를 가중시키고 있다. 이러한 산업적 제약을 고려할 때, 다양한 환경에서도 일정 수준의 정확도와 실시간성을 확보할 수 있는 object detection 기반 모델의 비교 연구가 요구된다. 하지만 다양한 AI 모델 중 섬유 검사에 가장 적합한 AI 모델이 어떠한 것인가에 대한 지표는 거의 찾아볼 수 없으며 다양한 유형의 섬유에 대하여 가장 높은 성능을 보이는 AI 모델이 어떠한 것인가에 대한 정보도 보편화되어 있지 않은 실상이다. 그래서 본 연구에서는 대표적인 object detection 모델인 Yolov4, YOLOX, RT-DETR을 동일 실험 환경에서 비교하여 섬유 원단에 가장 적합한 AI 모델이 어떠한 것인가에 대하여 검증을 진행해 보았다.

2. 이론적 배경

2.1. 사전 검토

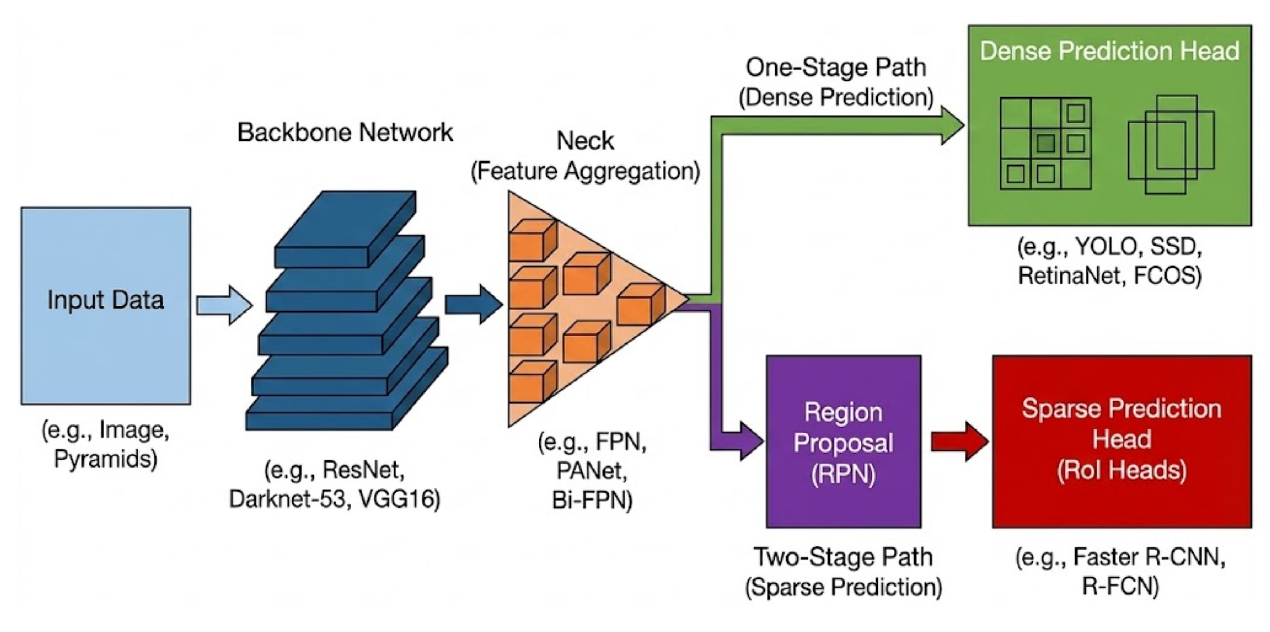

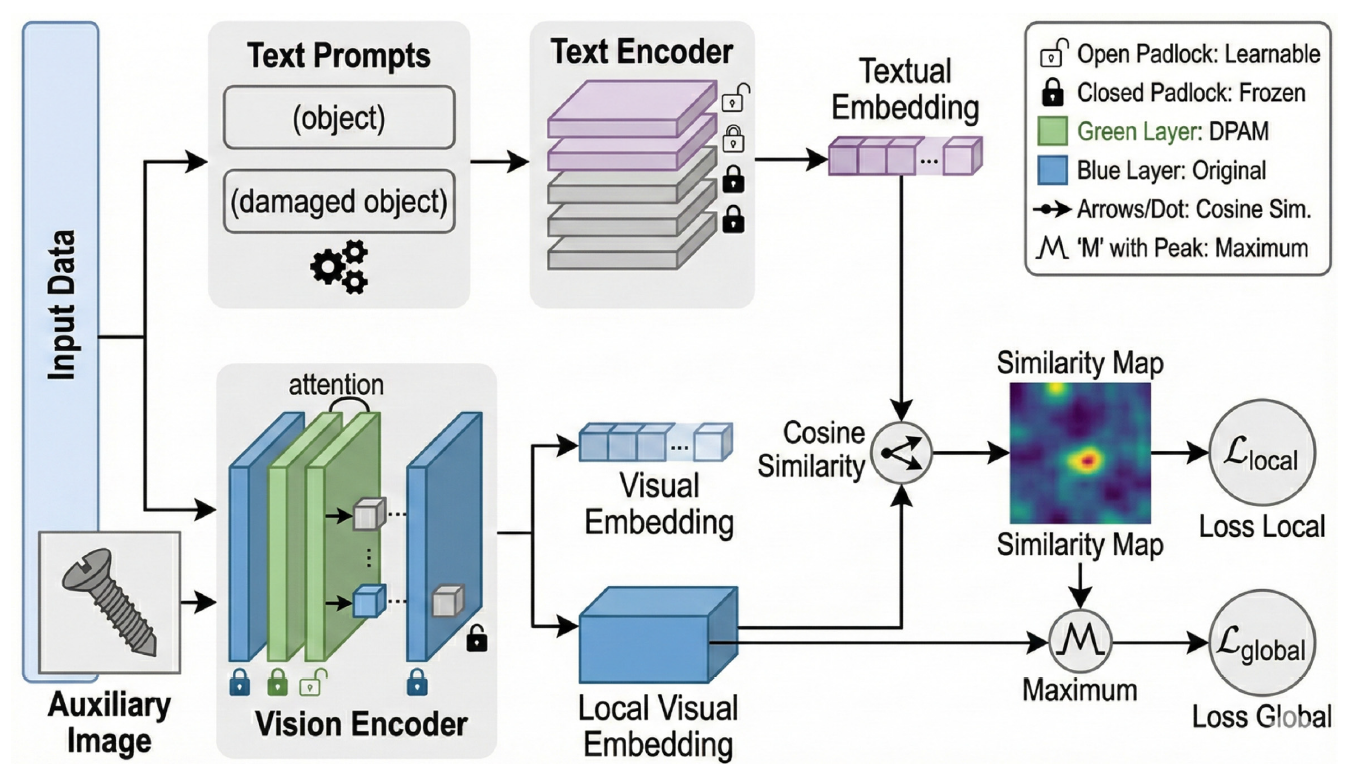

본 연구에서는 섬유의 결함을 검출하기 위해 가장 적합한 AI 모델이 어떠한 것인지에 관하여 연구하기 위하여 다양한 모델들에 대하여 사전 검토를 진행하였다. 보편적으로 image 기반 inspection의 경우 Figure 1 및 Figure 2와 같은 object detection과 anomaly detection AI 모델들이 사용되고 있다.

사전 검토를 진행한 결과, 결함 image data를 취득하기 어려운 제조업 현장 특성상 정상 데이터만을 사용해 학습이 가능한 anomaly detection AI 모델을 사용하는 것이 가장 적합해 보이지만 원단 다품종의 경우 조직, 색상, 표면 질감별로 AI 모델들을 모두 만들어 줘야 해서 AI 모델 학습에 많은 시간이 소요되며 추가로 inference를 담당하는 GPU server에 많은 수의 모델이 올라가야 해서 대부분 중소기업 위주인 섬유 산업 특성상 H/W 가격이 올라가는 것은 적용에 어려움이 존재할 것으로 예상되어 본 연구에서는 섬유 염색 제조 현장에서 바로 반영이 가능할 것으로 예상되는 object detection 모델을 사용하여 연구를 진행하였다[5].

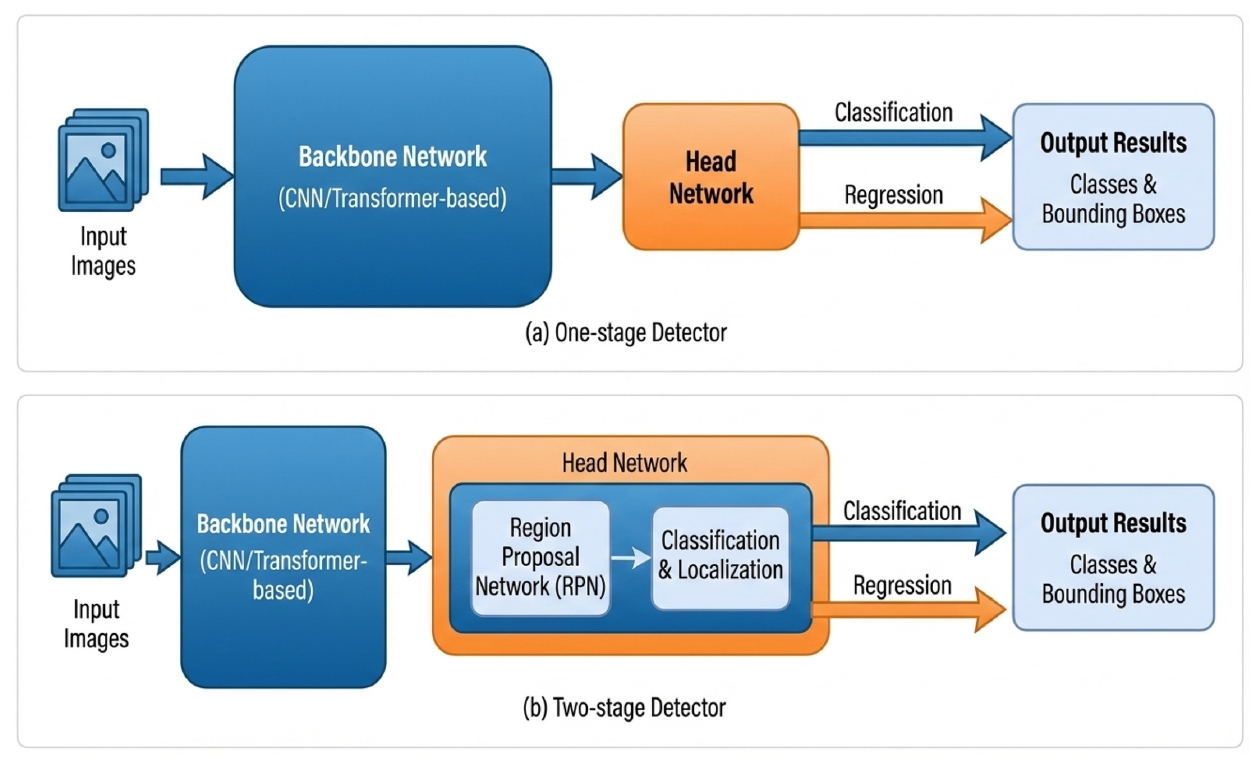

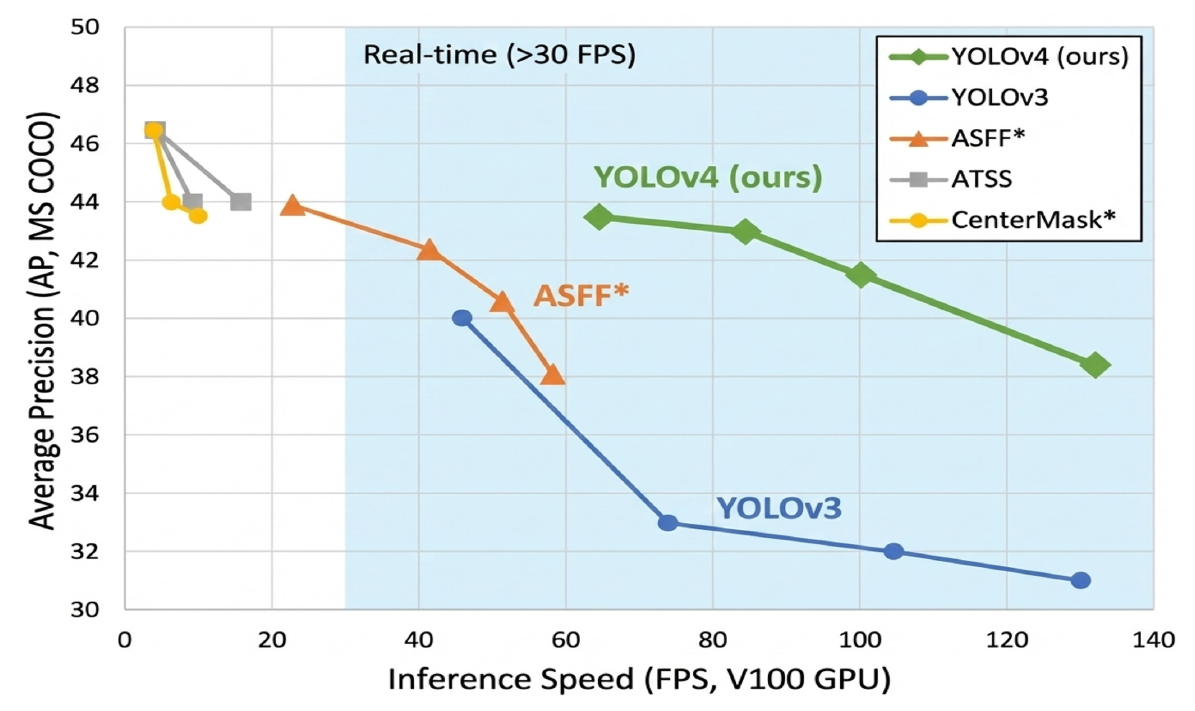

2.2. Object Detection 모델 검토

Object Detection AI 모델도 오랜 시간 연구가 이루어진 만큼 매우 다양한 AI 모델이 존재하고 있다. 대표적으로 Figure 3과 같은 one-stage object detection, two-stage object detection 모델이 있으며, 본 연구에서는 50 MPM(miter per minute) 이상으로 작동하는 검단기 에서도 사용할 수 있어 야 하므로 실시간성 확보가 어려운 모델은 제외하고 고속 처리가 가능한 모델들에 대하여 비교를 하였으며, 상업용으로 사용이 가능한 라이선스 정책을 가지고 있으면서 비교적 쉽게 접할 수 있는 AI 모델들인 Yolov4, YOLOX, RTDETR 3가지 모델에 대해서 비교해 보았다[6].

2.3. Yolov4 Model

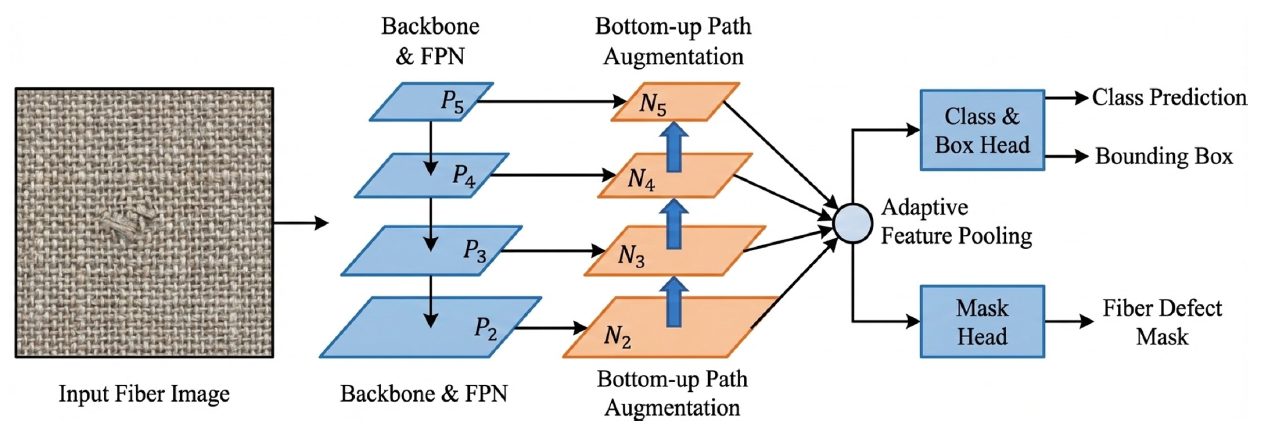

Yolov4(you only look once)의 BoF(bag of freebies), BoS(bag of specials) 기법을 체계적으로 구성하여 단일 GPU 학습이 가능한 객체 검출 모델이다[7]. BoF 기법에는 Mosaic 증강, SAT(self-adversarial training), CmBN(cross minibatch normalization) 등이 포함되어 추론 속도는 늘리지 않고 정확도를 확보하는 기법이다. Figure 4의 예시와 같다.

Figure 4.

BoS 기법은 SAM(spatial attention module)이나 Figure 5와 같은 PAN(path aggregation network) 구조 등이 포함되어 자원을 더 사용해 정확도를 확보한다[8].

다른 one-stage 방식인 EfficientDet 모델에 비해 약 2배 빠른 추론이 가능하여 실시간(real-time) 운용이 가능하다. 하지만 Yolov4는 앵커 기반(anchor base)이라 데이터셋에 따라 앵커(anchor) 재설정 등이 필요해 앵커 프리(anchor free), 트랜스포머(transformer) 모델에 비해 유연성이 떨어진다. Figure 6에서 확인할 수 있다.

2.4. YOLOX Model

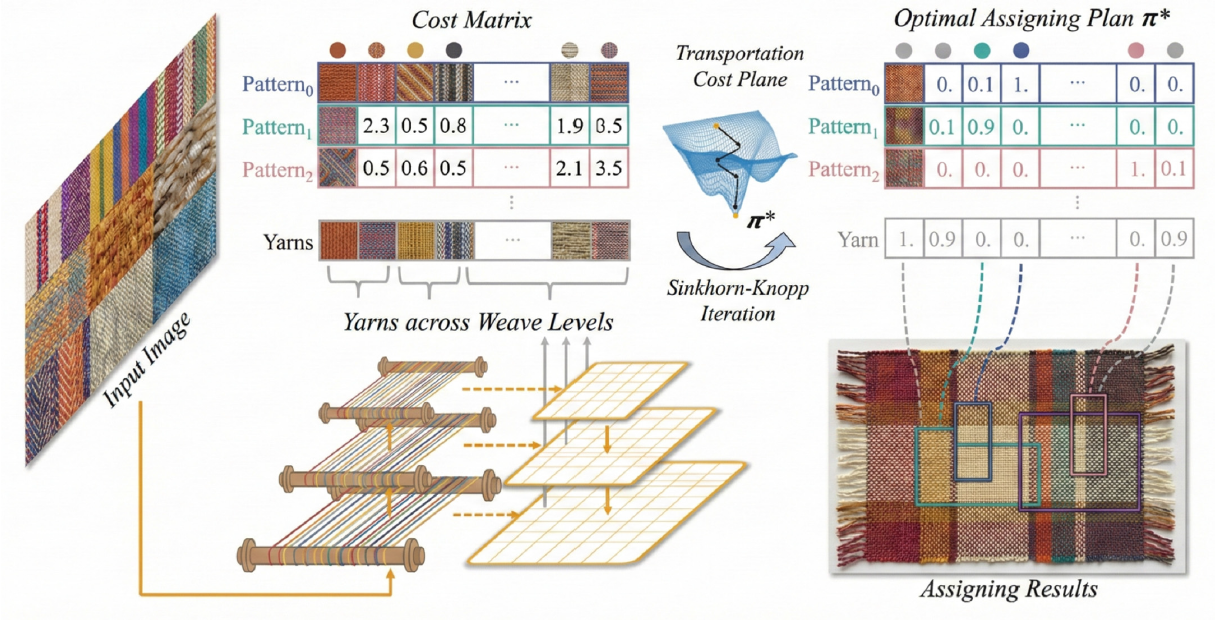

YOLOX 모델은 다른 대부분의 Yolo 모델 들과 다르게 anchor free 모델로 객체의 높이, 폭을 직접 예측한다[9]. anchor free라서 하나의 위치에 복수의 객체가 라벨링 될 수 있다. 이를 해결하고 Figure 7과 같은 OTA(optimal transport assignment)의 오버헤드 문제점을 해결하기 위해 Iteration 없이 수행하는 SimOTA(simple optimal transport assignment)을 사용해 라벨을 동적 할당하여 사용한다[10,11].

기존과 다르게 디커플드 헤드(decoupled head)로 하나의 head가 아닌 회귀(regression), 분류(classification), 객체성(objectness)으로 분리하여 성능을 향상시키지만, 계산량이 증가하여 추론 지연이 발생한다.

2.5. RT-DETR Model

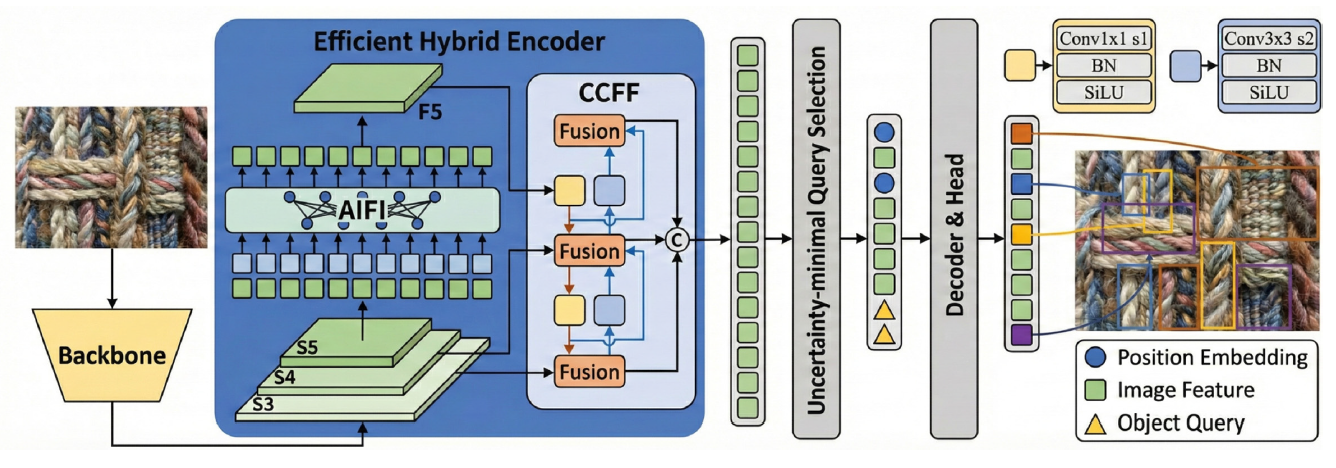

자원 소모량이 많은 DETR(detection transformer) 기반에 실시간성을 더한 Yolo 모델이 Figure 8과 같은 RT-DETR(realtime detection transformer) 이다. 헝가리안 매칭을 사용하는 end-to-end 구조라 기존의 Yolo 모델과 다르게 NMS(nonmaximum suppression)과 같은 후처리 과정이 필요 없다. 이로 인해 추론 지연이 발생하지 않고 안정적으로 추론 속도가 유지된다[12]. AIFI(attention-based intra-scale feature interactio)와 CCFF(CNN-based cross-scale feature fusion) 모듈로 구성된 효율적인 하이브드 인코더(efficient hybrid encoder)로 multi scale feature로 인해 발생하는 계산 변목을 해결할 수 있다[13]. 그로 인해 다른 DETR모델에 비해 빠르지만, 트랜스포 기반의 모델이기에 다른 초경량 Yolo 모델에 비해 필요한 자원 및 시간이 상대적으로 필요하다[14].

3. 실 험

3.1. 데이터 수집

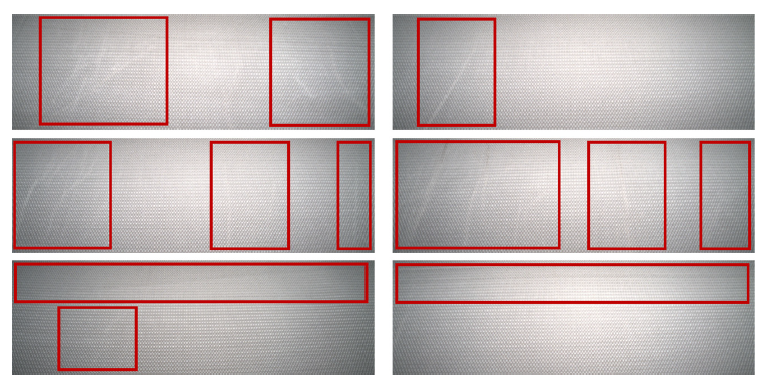

본 연구를 위해 사용한 데이터셋은 Kaggle에서 제공되는 fabric defects dataset을 사용하였다. AI 모델 학습 진행 시 train data 4,354장, valid data 1,243장 test data 626장을 사용해 학습을 진행하였으며, 결함 데이터와 정상 데이터(negative)는 8:2 비율로 data set을 구성하여 학습에 사용하였다. 이는 image filter 기반 data augmentation 방식이 적용된 수량이다. Figure 9는 검출된 결함 이미지 예시이다.

3.2. 실험 방법

본 연구에서는 다양한 섬유 원단 환경에서 object detection 기반 딥러닝 모델의 결점 검출 성능을 비교·분석하기 위하여 체계적인 실험 절차를 설계하였다. 실험의 일관성과 공정성을 확보하기 위해 모든 모델은 동일한 데이터 세트 구성, 데이터 분할 방식, 학습 조건 및 입력 해상도를 적용하여 학습과 평가를 수행하였다.

실험에 사용된 데이터 세트는 공개 섬유 결점 이미지 데이터 세트로부터 수집되었으며, Kaggle 플랫폼에서 제공되는 두 개의 데이터 세트를 통합하여 구성하였다. 구체적으로는 fabric defect dataset[15]과 textile defect dataset[16]을 활용하였으며, 해당 데이터 세트들은 다양한 원단 질감과 결점 유형을 포함하고 있어 실제 산업 환경을 반영한 실험이 가능하다. 각 데이터 세트는 섬유 표면에서 발생하는 찢어짐, 오염, 구멍, 조직 불균일 등의 결점 이미지를 포함하고 있으며, 본 연구에서는 object detection 학습에 적합하도록 결점 영역에 대한 바운딩 박스를 재정의하고 라벨을 통합 정리하였다. 수집된 데이터는 결점 유형별 샘플 수의 불균형이 존재하는 특성을 보였으며, 이는 학습 과정에서 특정 클래스에 대한 편향을 유발할 수 있다. 이를 완화하기 위해 모델 내부의 데이터 증강 기법에 의존하지 않고, image processing 기반의 사전 데이터 증강을 적용하여 클래스 간 데이터 분포를 조정하였다. 데이터 증강 과정에서는 원단의 물리적 특성과 결점 형태의 시각적 일관성을 유지하기 위해 rotation, horizontal 및 vertical flip, brightness 조정, contrast 변화, sharpening 기법을 제한적으로 적용하였다. 모든 증강 연산은 결점의 위치 및 형태가 왜곡되지 않는 범위 내에서 수행되었다.

데이터 세트는 학습, 검증, 테스트 용도로 각각 60%, 30%, 10%의 비율로 분할하여 사용하였다(train/validation/test=6:3:1). 모든 모델은 동일한 데이터 분할을 적용함으로써 데이터 구성 차이에 따른 성능 변화를 최소화하였다. 또한 object detection 모델 간의 구조적 성능을 순수하게 비교하기 위해 CutMix, MixUp과 같은 모델 내부 혼합 기반 증강 기법은 모든 실험에서 제외하였다. 입력 이미지 해상도에 따른 성능 차이를 제거하기 위해 모든 모델의 입력 크기는 640×640으로 고정하였다. 학습은 동일한 하드웨어 환경에서 수행되었으며, 실험 시스템은 Intel Xeon Silver 4510 프로세서 2개, 256GB RAM, NVIDIA RTX 3090 GPU 4대로 구성되었다. 각 모델은 batch size 640 조건에서 학습되었으며, 충분한 수렴을 확보하기 위해 최대 50,000 epoch까지 학습을 진행하였다. 이를 통해 모델별 학습 안정성과 성능 변화 양상을 장기적으로 관찰할 수 있도록 하였다. 비교 대상 모델은 YOLOv4, YOLOX, RT-DETR의 세 가지 object detection 모델이며, 모든 모델은 동일한 학습·검증·평가 절차를 거쳐 성능을 산출하였다. 모델 성능 평가는 accuracy, precision, recall, F1-score의 네 가지 지표를 사용하였다. Accuracy는 전체 예측 결과 중 올바르게 분류된 비율을 나타내며, Precision은 결점으로 예측된 영역 중 실제 결점에 해당하는 비율을 의미한다. Recall은 실제 결점 영역 중 모델이 검출에 성공한 비율을 나타내며, F1-score는 Precision과 Recall의 조화 평균으로서 클래스 불균형 환경에서의 종합적인 검출 성능을 평가하기 위해 사용하였다. 각 지표의 수식은 식 (1)–(4)에 정의하였다.

(4)

[TeX:] $$\text { F1-Score }(\%)=\frac{2 \times \text { Precision × Recall }}{\text { Precision } \text { × } \text { Recall }}$$TP (True Positive) : number of questions matching the correct answer (correct answer number)

TN (True Negative) : number of times the correct answer is judged as correct (correct answer number)

FP (False Positive) : number of questions that output an answer that is not correct (number of false positives)

FN (False Negative) : number of missed correct questions (number of missed questions)

4. 결과 및 고찰

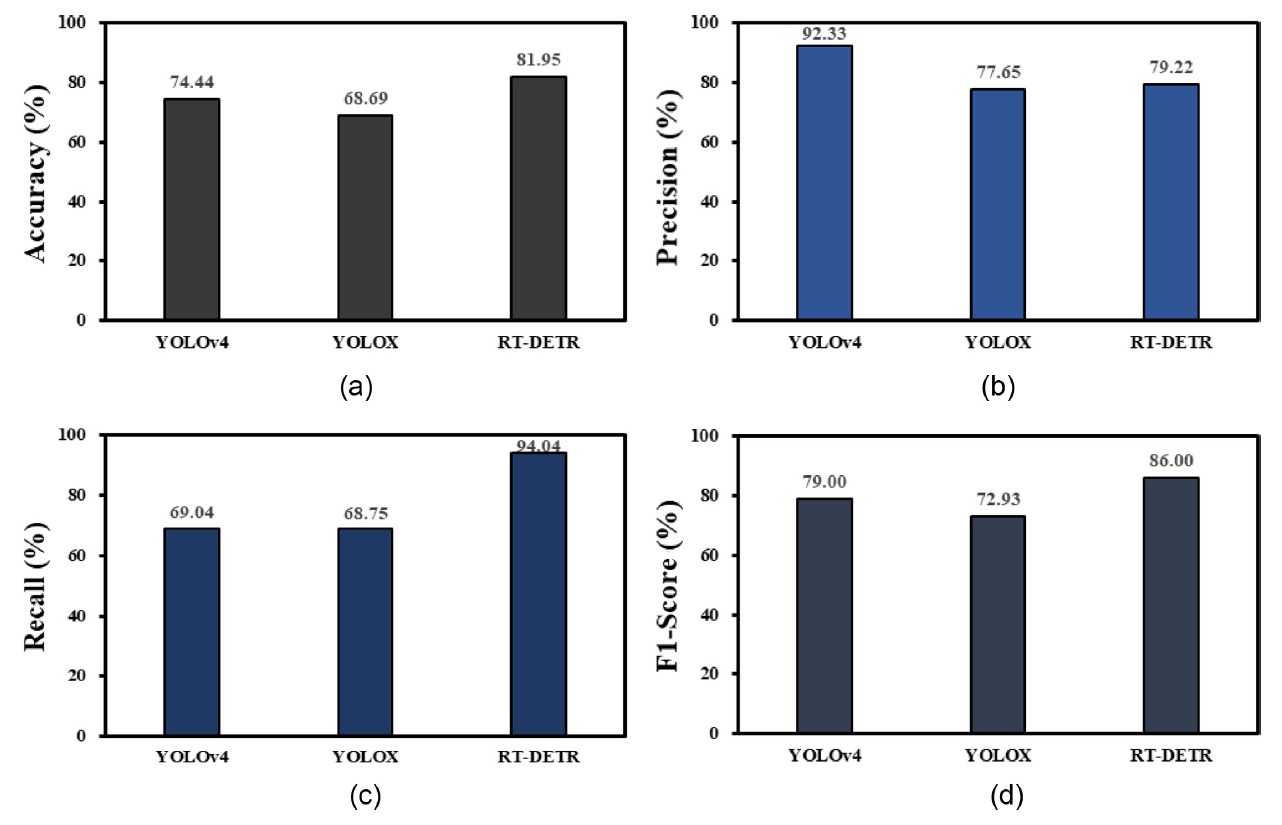

본 연구에서는 동일한 섬유 원단 결점 데이터셋과 학습 조건하에 YOLOv4, YOLOX, RT-DETR 모델의 성능을 비교 분석하였다. 각 모델의 성능 평가는 accuracy, precision, recall, F1-score의 네 가지 지표를 기준으로 수행하였으며, 각 지표는 식 (1)–(4)에 따라 계산하였다. 정량적 분석 결과는 Table 1과 Figure 10에 제시하였다.

분석 결과, accuracy는 RT-DETR 모델이 81.95%로 가장 높은 값을 보였으며, 이는 전체 예측 결과 중 올바르게 분류된 비율이 가장 높았음을 의미한다. Precision의 경우 YOLOv4 모델이 92.33%로 가장 우수한 성능을 나타냈는데, 이는 결점으로 판단한 영역 중 실제 결점에 해당하는 비율이 가장 높았음을 시사한다. 반면 Recall은 RT-DETR 모델이 94.04%로 가장 높은 값을 기록하였으며, F1-score 역시 RT-DETR 모델이 86.00%로 가장 우수한 성능을 보였다. 종합적으로 볼 때, RT-DETR 모델은 accuracy, recall, F1-score의 세 가지 지표에서 가장 우수한 성능을 나타내었다. 이러한 결과는 각 모델의 구조적 특성과 섬유 원단 결점 데이터의 특성 간의 상관관계로 해석할 수 있다. YOLOv4 모델은 단일 단계(one-stage) 기반의 밀집 예측(dense prediction) 구조를 가지며, 비교적 단순한 구조와 강한 지역 특징 학습 능력을 바탕으로 결점 후보 영역에 대한 정밀한 판단을 수행하는 데 강점을 보였다. 이로 인해 오검출을 최소화하는 precision 지표에서는 가장 우수한 성능을 나타낸 것으로 판단된다. 그러나 섬유 원단 결점은 크기, 형태, 명암 대비가 매우 다양하게 분포하며, 미세 결점의 경우 배경 패턴과의 구분이 어려운 특성을 가진다. 이러한 환경에서는 결점 후보를 최대한 놓치지 않는 검출 전략이 중요하며, YOLOv4는 상대적으로 보수적인 예측 특성으로 인해 일부 결점이 누락되었을 가능성이 있다.

Table 1.

| Models type | Accuracy (%) | Precision (%) | Recall (%) | F1-Score (%) |

|---|---|---|---|---|

| YOLOv4 | 74.44 | 92.33 | 69.04 | 79.00 |

| YOLOX | 68.69 | 77.65 | 68.75 | 72.93 |

| RT-DETR | 81.95 | 79.22 | 94.04 | 86.00 |

Figure 10.

반면 RT-DETR 모델은 transformer 기반 구조를 통해 전역적인 문맥 정보를 효과적으로 활용할 수 있으며, 다중 객체 간의 관계를 동시에 고려하는 예측 메커니즘을 가진다. 이러한 특성은 반복적인 패턴과 복잡한 질감을 갖는 섬유 원단 이미지에서 결점과 배경 간의 차이를 보다 안정적으로 구분하는 데 기여한 것으로 판단된다. 특히 높은 Recall 성능은 미세하거나 불규칙한 결점을 놓치지 않고 검출하는 능력이 우수함을 의미하며, 이는 실제 산업 현장에서 결점 누락을 최소화해야 하는 요구사항과 밀접하게 부합한다. 이와 같은 이유로 RT-DETR 모델은 precision 단일 지표에서는 YOLOv4에 비해 다소 낮은 성능을 보였으나, recall과 F1-score 측면에서는 보다 균형 잡힌 성능을 나타낸 것으로 해석된다.

본 연구 결과는 섬유 원단 결점 검사 문제에서 단일 성능 지표만으로 모델의 우수성을 판단하는 것이 적절하지 않음을 시사한다. 예를 들어 precision이 높은 모델은 오검출을 줄이는 데 유리하지만, 결점 누락이 허용되지 않는 검사 공정에서는 recall이 높은 모델이 더 적합할 수 있다. 이러한 관점에서 RT-DETR 모델은 섬유 원단 검사와 같이 결점 검출의 누락 비용이 큰 산업 환경에서 보다 실용적인 대안이 될 수 있음을 확인하였다. 다만 본 연구는 공개 데이터 기반의 섬유 원단 이미지와 제한된 결점 유형을 대상으로 수행되었으며, 실제 생산 라인의 조명 변화, 원단 장력 변화, 카메라 설치 조건과 같은 환경적 요인은 충분히 반영하지 못했다는 한계를 가진다. 향후 연구에서는 실시간 처리 속도 분석, 결점 크기별 성능 비교, 원단 유형별 세부 분석 등을 추가함으로써 모델의 산업 현장 적용 가능성을 보다 정밀하게 검증할 필요가 있다.

5. 결 론

본 연구에서는 섬유 원단 결점 분석을 대상으로 대표적인 object detection 기반 딥러닝 모델인 YOLOv4, YOLOX, RT-DETR의 성능을 동일한 데이터 세트 및 학습 환경에서 비교 분석하였다. 이를 통해 모델 구조에 따른 성능 특성과 산업 적용 가능성을 정량적으로 평가하고, 섬유 산업 현장에 적합한 AI 모델 선택에 대한 기준을 제시하고자 하였다.

실험 결과, YOLOv4 모델은 높은 정밀도를 보이며 정상 영역을 불량으로 오인하는 빈도가 상대적으로 낮은 특성을 나타냈다. 반면 재현율이 낮아 일부 결점을 정상으로 판단하는 경향이 관찰되었으며, 이는 불량 검출의 누락보다 오검출을 최소화해야 하는 공정 환경에 적합한 특성으로 해석할 수 있다. 따라서 YOLOv4는 품질 기준이 엄격하고 불필요한 불량 판정을 최소화해야 하는 검사 공정에 효과적으로 적용될 수 있을 것으로 판단된다.

YOLOX 모델은 본 연구에서 비교한 모델 중 전반적으로 가장 낮은 성능을 보였다. 특히 anchor-free 구조가 다양한 크기와 형태를 가지는 섬유 원단 결점의 특성을 충분히 반영하지 못한 것으로 분석된다. 다만 YOLOX는 네트워크 구조의 단순성과 확장성이 우수한 모델로, 멀티 스케일 학습 전략이나 데이터 증강 기법의 세밀한 조정을 통해 성능 개선의 가능성이 존재한다. 이에 따라 YOLOX 모델의 섬유 결점 검출 성능 향상을 위한 구조적·학습적 개선에 대한 추가 연구가 필요하다. RT-DETR 모델은 정확도와 재현율 모두에서 가장 우수한 성능을 나타냈으며, 특히 재현율 측면에서 타 모델 대비 현저히 높은 수치를 기록하였다. 이는 결점을 놓치는 것이 허용되지 않는 제품군이나 안전·품질 중심의 검사 공정에 매우 적합한 특성으로 해석된다. Transformer 기반 구조는 섬유 원단과 같이 반복적이면서도 미세한 패턴 변화를 포함하는 데이터에서 전역적인 특징(global feature)을 효과적으로 학습할 수 있는 장점을 가지는 것으로 판단된다. 다만 RT-DETR은 기존 CNN 기반 모델 대비 추론 속도가 상대적으로 낮아, 초고속 생산 라인과 같은 환경에서는 적용에 제약이 있을 수 있다.

본 연구의 학술적 의의는 섬유 원단 결점 분석이라는 특정 산업 도메인에서 다양한 object detection 모델을 동일 조건하에 비교함으로써, 모델 구조적 특성과 성능 간의 관계를 체계적으로 분석하였다는 점에 있다. 기존 연구들이 개별 모델의 적용 가능성에 초점을 맞춘 데 비해, 본 연구는 실제 산업 환경을 고려한 공정성 있는 비교 실험을 통해 모델 선택에 대한 실질적인 판단 근거를 제시하였다는 점에서 의미를 가진다. 향후 연구로는 RT-DETR이 가지는 기존 CNN 기반 모델 대비 낮은 추론 속도에 의한 초고속 생산 라인과 같은 환경에서는 적용 제약을 해결하기 위하여 초고속 공정 환경을 고려한 경량화된 transformer 기반 모델 설계, 실시간성을 향상시키기 위한 지연 시간 최적화 기법에 대한 연구가 필요할 것으로 판단된다. 또한 실제 생산 라인에서 발생하는 신규 결점 유형에 대한 대응을 위해 object detection과 anomaly detection을 결합한 하이브리드 구조에 대한 연구 역시 유의미한 확장 방향이 될 수 있다. 더 나아가 다양한 섬유 소재와 가공 조건을 포함한 대규모 데이터 세트 구축을 통해 모델의 일반화 성능을 검증하는 후속 연구가 필요할 것으로 판단된다.

References

- 1 E. S. Nam, Y. S. Choi, and C. K. Lee, " A Study on the Defect Detection of Fabrics using Deep Learning, " SMJ, 2022, 11, 92− 98.custom:[[[-]]]

- 2 M. J. Kim and J. H. Shin, "A Development of Vision-based Defect Detection Methodology Using Transfer Learning of Convolutional Neural Network, " Kor. J. Comput. Design Eng., 2020, 25, 246−255.custom:[[[-]]]

- 3 A. Rasheed, B. Zafar, A. Rasheed, N. Ali, M. Sajid, S. H. Dar, U. Habib, T. Shehryar, and M. T. Mahmood, "Fabric Defect Detection Using Computer V ision T echniques: A Comprehensive Review, " Math. Probl. Eng., 2020, 2020, 1−24.custom:[[[-]]]

- 4 R. M. Haralick and L. G. Shapiro, "Glossary of Computer vision terms, " Pattern Recogniti., 1991, 24, 69−93.custom:[[[-]]]

- 5 Q. Zhou, G. Pang, Y. Tian, S. He, and J. Chen, " Anomalyclip : Object-Agnotic Prompt Learning for Zero-shot Anomaly Detection, " ICLR 2023, 2023, 11, 1−31.custom:[[[-]]]

- 6 J. Kang, S. Tariq, H. Oh, and S. S. Woo, "A Survey of Deep Learning-Based Object Detection Methods and Datasets for Overhead Imagery, " IEEE Access, 2022, 10, 20118−20134.custom:[[[-]]]

- 7 J. Y . Kim, " A Comparative Study on the Characteristics of each Version of Object Detection Model YOLO, " Korean Society of Computer Information Conference, Jeju, 2023, pp.75−78.custom:[[[-]]]

- 8 A. Bochkovskiy, C. Y. Wang, and H. Y. M. Liao, "YOLOv4 : Optimal Speed and Accuracy of Object Detection," arXiv preprint, doi: 10.48550/arXiv : 2004.10934, 2020custom:[[[-]]]

- 9 J. H. Bae, B. J. Kang, D. H. Kim, and K. H. Baek, "Performance Evaluation of LWIR Image Detection Using Fine-tuning of YOLOX Model, " J. Inst. Contr. Robot. Syst., 2024, 30, 685−690.custom:[[[-]]]

- 10 Z. Ge, S. Liu, F. Wang, Z. Li, and J. Sun, "YOLOX : Exceeding YOLO Series in 2021," arXiv preprint, doi: 10.48550/arXiv : 2107.08430, 2021.custom:[[[-]]]

- 11 Z. Ge, S. Liu, Z. Li, O. Yoshie, and J. Sun, "OTA : Optimal Transport Assignment for Object Detection, " 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Nashville, 2021, pp.303−312.custom:[[[-]]]

- 12 I. J. Jeon and S. H. Kim, "A Study on the Detection and Classification Model for Maritime Objects Using a Lightweight RT-DETR, " JKAIS, 2025, 26, 710−716.custom:[[[-]]]

- 13 Y . Zhao, W . Lv, S. Xu, J. Wei, G. Wang, Q. Dang, Y . Liu, and J. Chen, "DETRs Beat YOLOs on Real-time Object Detection," 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Vancouver, 2023, pp.16965-16974.custom:[[[-]]]

- 14 A. Bagri, V. Venugopal, R. Ezhumalai, K. Sivasailam, and B. Subramanian, "Fracture Detection and Localisation in Wrist and Hand Radiographs using Detection Transformer Variants", arXiv preprint, doi: 10.48550/arXiv : 2508.14129, 2025.custom:[[[-]]]

- 15 R. M. Shashi, "Fabric Defect Dataset" , Kaggle, 2021.custom:[[[-]]]

- 16 F . Nowshin, "Textile Defect Dataset" , Kaggle, 2022.custom:[[[-]]]